A l’occasion du colloque « IA au travail » organisé la semaine dernière au CESE (Conseil Economique Social et Environnemental), nous sommes allés rencontrer l’un de ses organisateurs, Christophe Gauthier, membre du think tank #leplusimportant.

Qu’est-ce que #Leplusimportant et qu’attendiez-vous de ce colloque sur l’IA ?

Nous sommes à la fois un Think tank et un action lab, au sein duquel je m’occupe notamment de tout ce qu’on appelle chez nous « Web des lumières », c’est à dire la manière dont on retrouve l’esprit des lumières dans le digital.

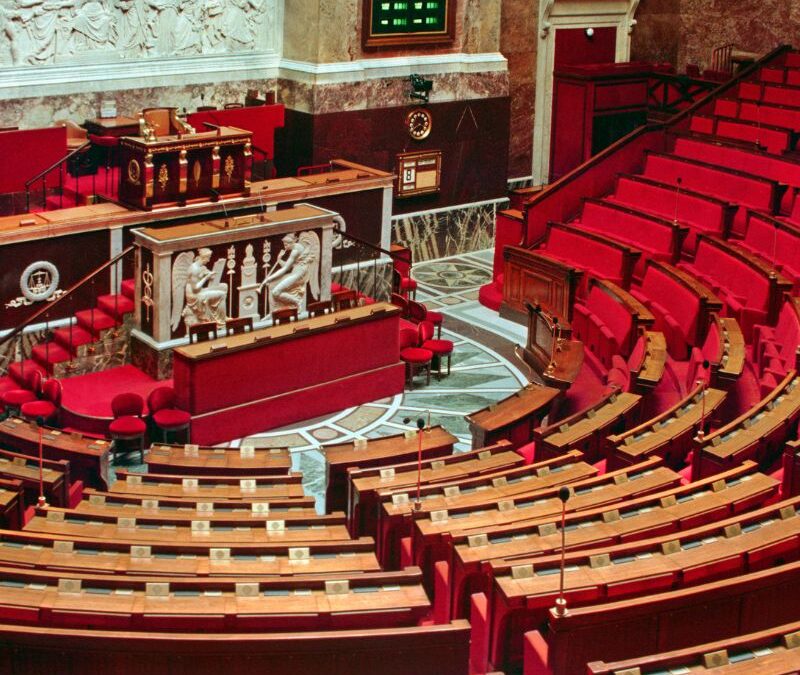

A l’issue du colloque, nous aimerions provoquer une réflexion commune des différents acteurs pour fonder un « Observatoire de l’IA responsable au travail » avec l’ensemble des gens qui travaillent déjà sur le sujet. Nous aimerions que les bonnes volontés et les initiatives diverses se rassemblent autour du CESE.

On vit actuellement un temps d’effervescence médiatique autour de l’IA. N’est-ce pas une surpromesse comme celle du métavers ?

Quitte à être provocateur, je pense que l’IA n’existe pas.

A deux titres. Antonio Casilli par exemple dit qu’en réalité, dans la partie intelligence artificielle, ce qui est artificiel concerne la machine. L’intelligence, ce sont les humains qui font les annotations de la donnée pour que pour que la machine produise un résultat interprétable avec satisfaction.

Pour la seconde raison, je dirais surtout qu’en fait on appelle intelligence artificielle une conjonction de beaucoup de choses. Le cloud apporte une capacité de de calcul de stockage et de « scalabilité » qui rend possible de travailler dans des ensembles informatiques de très grandes puissances. La digitalisation des sociétés humaines entraîne une disponibilité de données de savoirs et d’activités, sans commune mesure avec ce que c’était il y a encore 20 ans.

Nous sommes face à une autre difficulté. Nous sommes dans un monde qui est à la fois très volatil et très complexe, au sens des multiples paramètres qu’il faut pouvoir intégrer dans la prise de décision. Au regard de cette difficulté, je pense que l’humanité est mûre pour utiliser des outils qui s’appellent « Intelligence Artificielle », outils qu’elle manipule ou qu’elle expérimente en réalité depuis 60 ans ou 70 ans.

Pourquoi affirmer que l’humanité est mûre pour l’IA ?

Parce que nous évoluons dans un monde beaucoup plus interconnecté, beaucoup plus mondialisé où chacun se soucie de beaucoup plus de paramètres et de famille de règles en tension mutuelle, dirait Julie Ricard.

En 2023, une étude Oracle disait que 71% des Français avaient déjà renoncé à prendre des décisions, parce qu’ils avaient trop de données à prendre en compte ! Nous sommes conscients d’être très interdépendants, beaucoup plus qu’avant. Ce monde extrêmement changeant et difficile à lire a besoin d’une nouvelle classe d’outils. Et c’est pour cela que je pense que l’humanité est mûre pour l’intelligence artificielle.

N’est-ce pas un voeu pieux de poser la question de la responsabilité sociale de l’IA ?

Chacun met des choses très différentes derrière le mot « responsable ». C’est d’ailleurs pour ça qu’on a cherché dans le colloque, à inviter des gens venus d’horizons différents et qui mettent eux aussi des définitions différentes derrière cette notion de responsabilité.

On peut l’entendre au sens de responsabilité légale qui renvoie à tout un tas de sujets sur lesquels le Droit est en train de s’équiper. On peut aussi penser responsabilité en termes de frugalité et d’éco responsabilité. En ce sens, la Tech est de plus en plus divergente par rapport aux accords de Paris ou aux enjeux de sobriété énergétique et des limites planétaires. Les enjeux sociaux sont évidemment également déterminants.

Nous souhaitons qu’un Observatoire de l’IA responsable au travail aborde toutes ces facettes.

L’IA se présente un peu à nous comme une espèce de Janus avec deux faces : un grand risque ou une merveilleuse opportunité. Comment vous situez-vous ?

Je répondrai en disant que je fuis la manipulation et la simplification.

Les plateformes digitales cherchent à nous faire régresser vers un stade psychologique de petite enfance qui est toujours en mode bâton ou carotte. Pour le coup, leur comportement n’est responsable. Ils instrumentalisent ce manichéisme qui est une manipulation de nos émotions. On n’arrête pas de nous abreuver d’une IA qui aurait déjà la capacité de tuer, une autre de cacher des programmes qu’elle élabore pour elle-même. C’est scandaleux en fait de véhiculer ces allégations-là, parce c’est refuser notre propre responsabilité en partant du principe que ce qui arrive « ce n’est pas notre faute, c’est la machine qui s’est décidée toute seule » ! Alors que c’est faux. L’IA n’est pas une vie animale autonome. Pourtant, ces technologies ne sont pas neutres. C’est pour ça que #Leplusimportant insiste sur la question de la responsabilité et des choix que nous effectuons. A nous de savoir ce que nous voulons faire de cette classe d’outils.

Dans l’IA, ce qui est artificiel concerne la machine.

Dans la même thématique…

Difficultés de recrutement : quelles solutions face à un marché sous tension?

Malgré la hausse du chômage, les difficultés de recrutement persistent. Découvrez les stratégies pour attirer et retenir les talents.

Réforme des retraites : analyse et perspectives de Raymond Soubie

Découvrez les enjeux de la réforme des retraites et les analyses de Raymond Soubie, sur le « conclave social » dans La Tribune.

Discours de politique générale : la méthode du conclave ?

Analyse du discours de François Bayrou : retraites, budget, travail, production et stratégie IA, dans un contexte économique incertain.